Сегодня расскажем о первичных настройках для продвижения блога на WordPress.

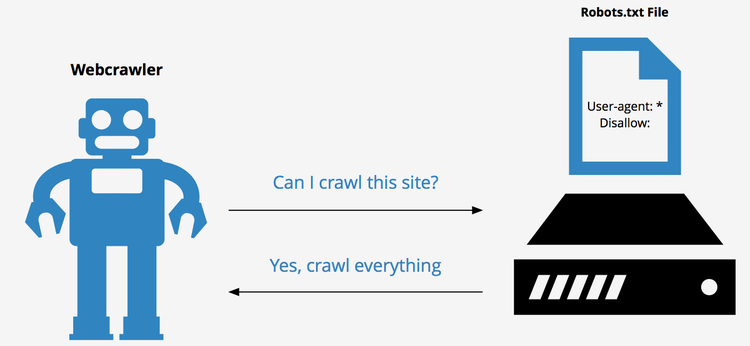

Итак, когда ваш блог WordPress впервые выходит в свет, то его сразу начинают сканировать поисковые роботы. Как вы думаете с чего они начинают?

Первым делом в корневой директории поисковики ищут файл robots.txt

Они же роботы - вот и файл для них так назван :)

В файле robots.txt мы можем написать поисковым роботам некий план обхода нашего сайта.

Мы можем явно сказать какие директории смотреть и какие исключать из индексации.

С первым пунктом понятно, а вот со вторым у новичков возникают вопросы.

Зачем намеренно исключать страницы и целые папки из индексации?

Вопрос справедливый и понятный. Давайте разбираться по порядку.

Дело в том, что при индексации поисковики стараются отбирать уникальные страницы, чтобы давать им больший приоритет, поскольку любая уникальная информация более ценная, чем бесконечно дублируемая, верно?

Все CMS, включая и WordPress, так или иначе дублируют часть контента.

Например интересующий нас движок для блоггеров дублирует начало каждого последнего поста (обычно до 10 шт) на стартовой странице, а также на каждой странице категорий, тегов, поиска и т. д.

Для того чтобы поисковики индексировали то что хотим мы, нам и нужно разобраться с файлом robots.txt.

Итак, вот основные особенности моего видения Грамотного Блога и правильной настройки под него файла robots.txt с целью защиты от дублирования контента.

Морду блога делаем статичной и продвигаем своими запросами

Обязательно посвящаем ее раздаче чумовой бесплатности за подписку.

Сами статьи блога (посты) при этом уходят на вложенную страницу и создают как раз дублирование мета-тегов, а именно: заголовок, описание главной страницы и ее ключевые слова.

Кроме того, страница с последними постами блога создает дублирование контента за счет того, что выводит весь текст последних постов до тега more (благодаря этому тегу избегается дублирование контента на 100%).

А вот страницы категорий, в свою очередь, снова дублируют контент постов, но уже ориентируясь на количество символов и исключая форматирование и картинки. Это, кстати, тоже дает более низкий процент дублирования.

В обычной ситуации, когда стартовая страница динамична и выводит последние посты блога, страницы категорий закрывают в файле robots.txt

Чтобы избежать дублирования, нам выгодней в случае со статичной стартовой страницей блога закрыть именно страницу с перечнем последних постов.

Так мы уберем дублирование названия стартовой страницы, его описания и ключевых слов в сравнении со страницей перечня постов.

А несколько страниц по категориям при этом могут преспокойно себе индексироваться, т.к. у каждой из них есть свое описание с индивидуальными ключами. Это более выгодно для продвижения той же главной страницы.

Тем не менее, бывают случаи, когда выгодно закрыть некоторые из категорий с целью избежания дублирования.